Quelques semaines après la conférence dédiée à l’iA, un nouvel événement sur le sujet avait lieu dans les locaux d’OoTech. Organisé en format « afterwork » par le Cluster Numérique OPEN NC, cet événement animé par trois intervenants se concentrait plutôt sur la partie technique et les cas d’usage. Au micro, on retrouvait deux experts, Boris Couffignal et Pierrick Sanchez, de chez Barrau Business System et toujours l’inénarrable et manifestement incontournable Jean-Simon Chaudier d’Analytics.nc. Petit résumé de ces présentations intimistes.

BBS, l’approche pragmatique

Un Club des DSI calédonien, n’est-ce pas là une formidable idée évoquée par le Président du Cluster Numérique OPEN NC, Hatem Bellagi, lors d’une courte introduction à l’afterwork ? Si la volonté de tous les « geeks » présents lors de cette réunion semblait tendre vers le rassemblement et la recherche de synergies, c’était bien (encore et toujours) l’intelligence artificielle qui était au cœur des débats. Cette fois, une approche plus technique et pragmatique était mise à l’honneur.

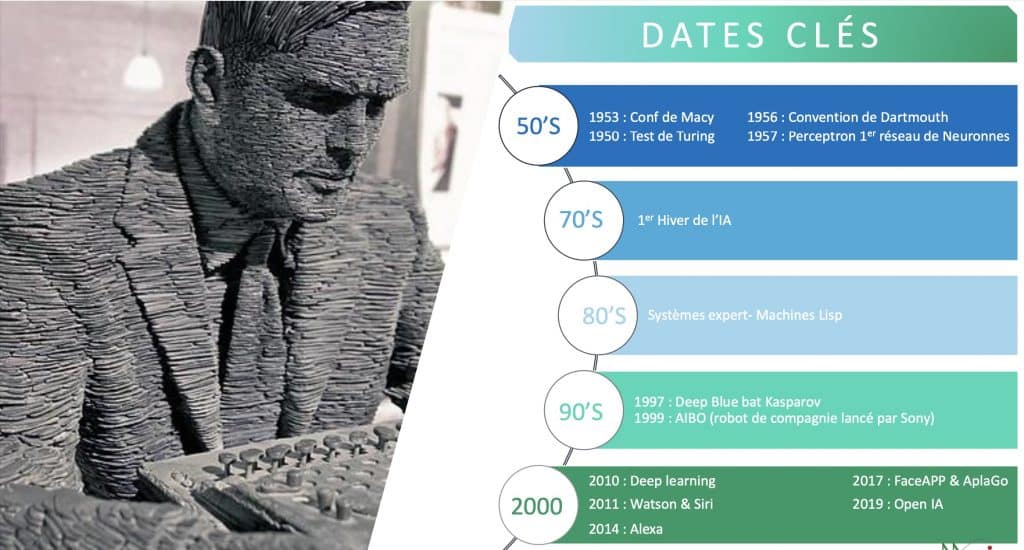

Après une brève description de ce qui fut, à l’origine, la boulangerie Maison Barrau, devenue, près d’un siècle et demi plus tard la société Barrau Business System, Boris Couffignal s’élança dans une présentation de l’histoire de l’iA. Du test de Turing en 1950 à l’Open AI de 2019 en passant par les Conférences de Macy et quelques personnalités « sachantes », le Directeur commercial de BBS se concentra sur le cœur du sujet : les deux incontournables « machine learning » et « deep learning ». Si le premier cité s’appuie en amont sur des données structurées et une extraction de ces données mangées par des algorithmes « connus », le second, pour sa part, se goinfre de données non-structurées qui sont ensuite avalées par un système neuronal d’algorithmes indéchiffrable. Le résultat : des « outputs » d’aide à la décision et à la prédiction.

Les deux compères de BBS présentèrent ensuite un cas pratique : une solution de maintenance 4.0 à mi-chemin entre intelligence basique et machine learning. L’objectif des balises installées sur des machines industrielles était d’enregistrer des variations propres à l’équipement et de faire travailler ensuite les algorithmes afin de détecter et de prédire les dysfonctionnements et anomalies. Pour résumer, les capteurs IoT couplés à une forme d’intelligence artificielle permet de prédire précisément lorsqu’une machine est en passe de casser, ou pire, de rendre l’âme. Utile pour ne pas rester en rade et stopper une partie de la production !

Analytics.nc, Jean-Simon again

La deuxième séquence de l’événement faisait intervenir, essoufflé par une folle course contre le temps, un Jean-Simon en chemise à carreaux. Après sa prestation lors de la conférence à la CCI, le public avait hâte de l’entendre nous parler de nouveaux cas d’usage. Son introduction sur la SLN, l’acteur phare du territoire en matière d’iA, rappelait ô combien ces technologies pouvaient être utiles dans l’industrie 4.0. Il nous présenta ensuite quelques autres acteurs connus – BCI, SG, Province Sud, OPT, UNC, GNC, CCI sans oublier l’IRD et la CPS – et des start-up – Le Trico, Insight, Bluecham, Visioon ou encore L2K Innovation – qui incluaient l’intelligence artificielle au cœur de leur produits et services.

Mais le « clou du spectacle » tenait en une problématique territoriale : « comment détecter les deux de forêts sur le sol calédonien ? ». Après avoir présenté un benchmark des solutions existantes, les partenaires de ce formidable projet et encore les différents tests de caméras et capteurs réalisés, Jean-Simon se concentra sur un zoom à propos de l’entraînement de l’algorithme. Le principe est finalement assez simple : engraisser l’algorithme à fortes doses de datas, locales ou internationales, afin d’améliorer la détection de ces catastrophes naturellement humaines.

Côté « sources de données », le projet s’est appuyé principalement sur 2 192 photos de feux disponibles en Open Source mises à disposition par la généreuse Université de San Diego et par l’ONG « AI for Mankind ». Mais qu’en serait-il si l’on y adossait 150 photos de paysages calédoniens intégrant des « schémas » de fumée ajoutés manuellement ? Et si on amplifiait cette approche « locale » par l’intermédiaire de 22 photos de « barbecues géants » prises par les caméras directement sur des zones calédoniennes exposées ? C’est dans la réponse que résidait la nouveauté : l’apprentissage de l’algorithme avec des données locales est bien plus efficace et améliore ainsi la détection de ces feux. Conclusion : les algorithmes sont comme nous, ils préfèrent manger local.

L’iA, un moteur de valeur pour les organisations

Ces deux cas pratiques tiraient dans le même sens : prouver que l’intelligence artificielle avait largement sa place et son utilité sur le territoire, quel que soit le secteur d’activité ou la taille de l’entreprise. Après avoir détaillé les résultats de deux études plus tard, l’une sur la valeur créée par l’IA dans les métiers des entreprises et l’autre sur les sources de création de valeur d’une intelligence artificielle, Jean-Simon expliquait : « la première étape dans l’approche de l’intelligence artificielle est d’identifier les opportunités. Vient ensuite le temps de lancer des POCs pour démontrer la valeur et l’apport de l’IA. Dernière étape et non des moindres, il faut ensuite débusquer et attirer les talents, peu nombreux et rémunérés entre 80 et 120K par an. », avant de conclure, « même si le lagon est très joli, c’est le défi intellectuel qui pousse les experts à intégrer une organisation. ». L’ancien de « la petite entreprise française » CapGemini pouvait décapsuler une bière et échanger avec le public présent, la séance venait d’être levée.